种子信息

[斯坦福公开课.卷积神经网络/深度学习/计算机视觉.春季.2017.英文字幕][Stanford CS231n - Convolutional Neural Networks for Visual Recognition (Spring 2017)][mp4]

[ 不计下载量 ]

| 选择操作: |

种子下载 | 加入收藏 | 分享到细语 |

|---|

| 文件名: |

ZiJingBT.CS231n - Convolutional Neural Networks for Visual Recognition (Spring 2017).torrent |

|---|

| 种子名称: |

CS231n - Convolutional Neural Networks for Visual Recognition (Spring 2017) |

|---|

| 信息: |

大小:

7.31 GB | 文件数:

48 | Info Hash:

3ccf3ee57bf1d22d3d8e2c30409212063c158b42 |

|---|

| 类别: |

学习 | 由 zyad86 (总版主 平原上的斯瓦迪亚骑士) 上传于 2017-09-21 19:21:37 |

|---|

| 活跃度: |

做种(5)/下载(0) | 完成下载 (390) (最近一次活动时间 2020-11-24 11:48:15 / 种子活动时间 2020-11-24 11:48:15) |

|---|

| 上传字幕: |

|

|---|

| 便笺: |

|

|---|

| 内容简介: |

转自HUD

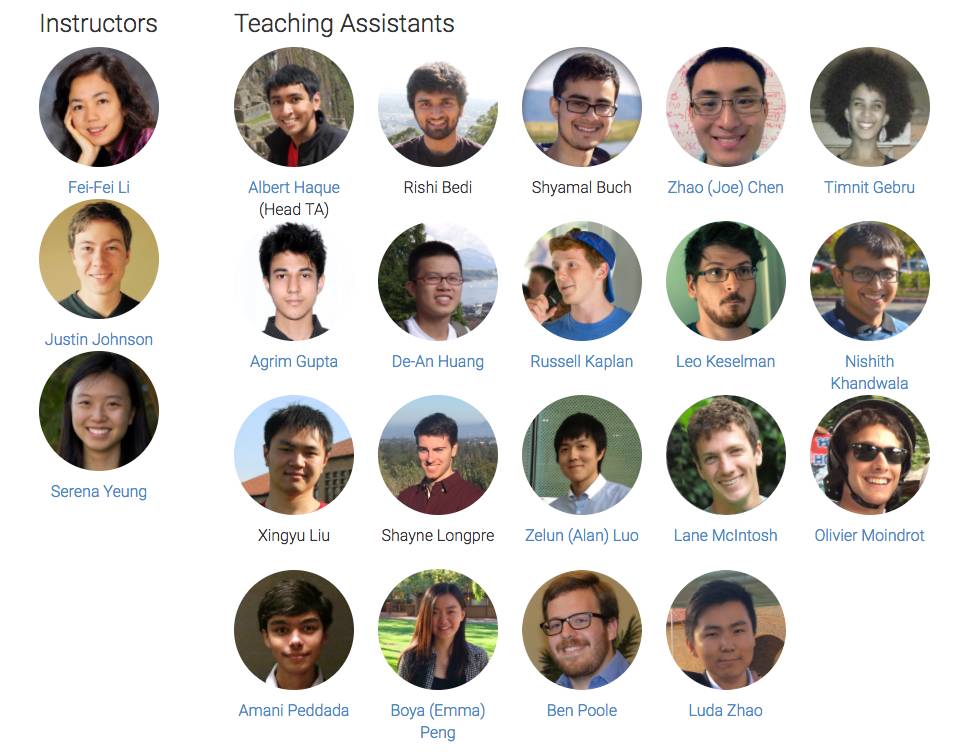

【新智元导读】斯坦福大学的 CS231n(全称:面向视觉识别的卷积神经网络)一直是计算机视觉和深度学习领域的经典课程,每年开课都吸引很多学生。今年是该课程第3次开课,学生达到730人(第1次150人,第2次350人)。今年的CS231n Spring的instructors 是李飞飞、Justin Johnson和Serena Yeung,并邀请 Ian Goodfellow 等人讲解GAN等重要主题。最近斯坦福大学公开了该课程的全部视频(配备英文)、slides等全部课程资料,新智元带来介绍。

全部课程视频(英文字幕):http://t.cn/R9Dfnxn

所有课程资料、PPT等:http://cs231n.stanford.edu/syllabus.html

课程描述

师和助教团队

计算机视觉在我们的社会中已经无处不在,例如应用于搜索、图像理解、apps、地图、医疗、无人机、自动驾驶汽车,等等。大部分应用的核心是视觉识别任务,例如图像分类、定位和检测。神经网络(又称“深度学习”)方法最新的进展大大提高了这些最先进的视觉识别系统的性能。本课程将带大家深入了解深度学习的架构,重点是学习这些任务,尤其是图像分类任务的端到端模型。

在为期10周的课程中,同学们将要学习实现、训练和调试自己的神经网络,并深入了解计算机视觉的最前沿的研究。期末作业将涉及训练一个数百万参数的卷积神经网络,并将其应用于最大的图像分类数据集(ImageNet)。我们将重点介绍如何创建图像识别问题,学习算法(例如反向传播算法),训练和微调网络的实用工程技巧,引导学生进行实际操作和最终的课程项目。本课程的背景知识和材料的大部分来自 ImageNet 挑战赛。

先修要求

熟练使用Python,C / C ++高级熟悉所有的类分配都将使用Python(并使用numpy)(我们为那些不熟悉Python的人提供了一个教程),但是一些深入学习的库 我们可以看看后面的类是用C ++编写的。 如果你有很多的编程经验,但使用不同的语言(例如C / C ++ / Matlab / Javascript),你可能会很好。

大学微积分,线性代数(例如MATH 19或41,MATH 51)您应该很乐意使用衍生词和理解矩阵向量运算和符号。

基本概率和统计学(例如CS 109或其他统计学课程)您应该知道概率的基础知识,高斯分布,平均值,标准偏差等。

CS229(机器学习)的等效知识我们将制定成本函数,采用导数和梯度下降执行优化。

课程 Notes:

课程Notes: http://cs231n.github.io/

模块0:准备内容

Python / Numpy 教程IPython Notebook 教程Google Cloud 教程Google Cloud with GPU教程AWS 教程

模块1:神经网络

图像分类:数据驱动的方法,k最近邻法,train/val/test splitsL1 / L2距离,超参数搜索,交叉验证

线性分类:支持向量机,Softmax参数化方法,bias技巧,hinge loss,交叉熵损失,L2正则化,web demo

优化:随机梯度下降本地搜索,学习率,分析/数值梯度

反向传播,直觉链规则解释,real-valued circuits,gradient flow中的模式

神经网络第1部分:建立架构生物神经元模型,激活函数,神经网络架构

神经网络第2部分:设置数据和损失预处理,权重初始化,批量归一化,正则化(L2 /dropout),损失函数

神经网络第3部分:学习和评估梯度检查,完整性检查,动量(+ nesterov),二阶方法,Adagrad / RMSprop,超参数优化,模型集合

把它放在一起:一个神经网络案例研究极小2D玩具数据示例

模块2:卷积神经网络

卷积神经网络:架构,卷积/池化层层,空间排列,层模式,层大小模式,AlexNet / ZFNet / VGGNet案例研究,计算考虑

理解和可视化卷积神经网络tSNE嵌入,deconvnets,数据梯度,fooling ConvNets,human comparisons

迁移学习和微调卷积神经网络

内容简介

Lecture 1:面向视觉识别的卷积神经网络课程简介

Lecture 1介绍了计算机视觉这一领域,讨论了其历史和关键性挑战。我们强调,计算机视觉涵盖各种各样的不同任务,尽管近期深度学习方法取得了一些成功,但我们仍然远远未能实现人类水平的视觉智能的目标。

关键词:计算机视觉,寒武纪爆炸,暗箱,Hubel 和 Wiesel,积木块世界,规范化切割,人脸检测,SIFT,空间金字塔匹配,定向梯度直方图,PASCAL视觉对象挑战赛,ImageNet挑战赛

PPT:cs231n.stanford.edu/slides/2017/cs231n_2017_lecture1.pdf

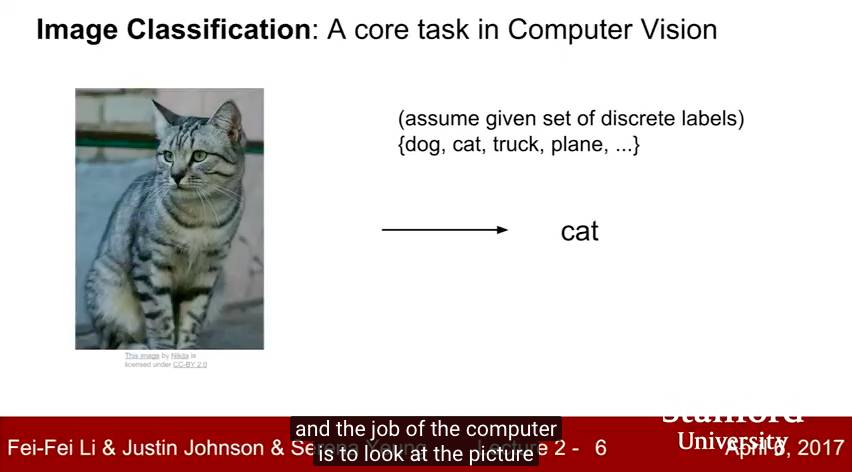

Lecture 2:图像分类

Lecture 2 使图像分类问题正式化。我们讨论了图像分类问题本身的难点,并介绍了数据驱动(data-driven)方法。我们讨论了两个简单的数据驱动图像分类算法:K-最近邻法(K-Nearest Neighbors)和线性分类(Linear Classifiers)方法,并介绍了超参数和交叉验证的概念。

关键词:图像分类,K最近邻,距离度量,超参数,交叉验证,线性分类器

PPT:cs231n.stanford.edu/slides/2017/cs231n_2017_lecture2.pdf

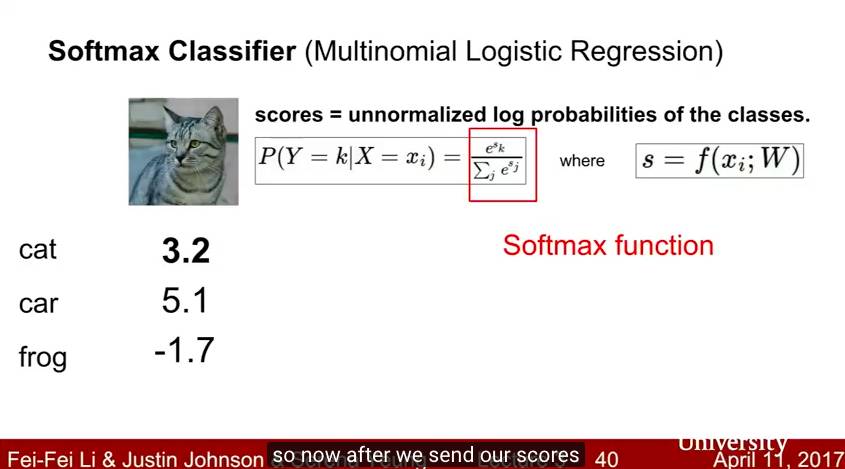

Lecture 3:损失函数和最优化

Lecture 3 继续讨论线性分类器。我们介绍了损失函数的概念,并讨论图像分类的两个常用的损失函数:多类SVM损失(multiclass SVM loss)和多项逻辑回归损失(multinomial logistic regression loss)。我们还介绍了正规化(regularization ),作为对付过拟合的机制,以及将权重衰减(weight decay )作为一个具体的例子。 我们还介绍了优化(optimization)的概念和随机梯度下降(stochastic gradient descent )算法。我们还简要讨论了计算机视觉特征表示(feature representation)的使用。

关键词:图像分类,线性分类器,SVM损失,正则化,多项逻辑回归,优化,随机梯度下降

PPT:cs231n.stanford.edu/slides/2017/cs231n_2017_lecture3.pdf

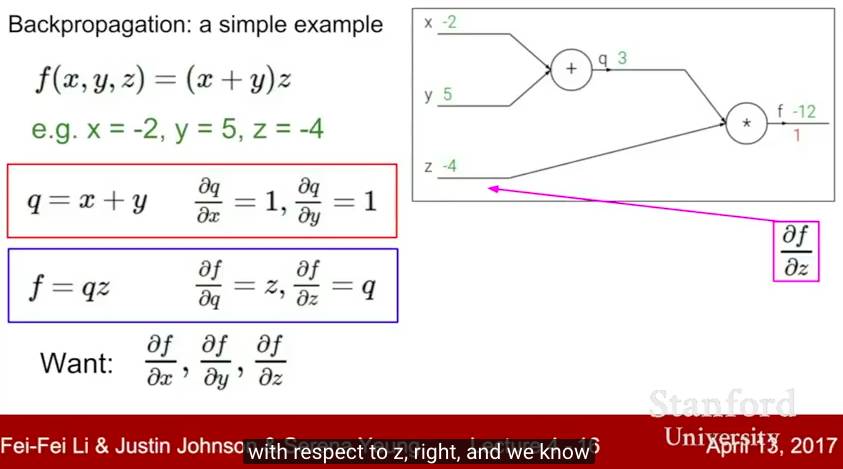

Lecture 4:神经网络介绍

在 Lecture 4 中,我们从线性分类器进展到全连接神经网络(fully-connected neural network)。本节介绍了计算梯度的反向传播算法(backpropagation algorithm),并简要讨论了人工神经网络与生物神经网络之间的关系。

关键词:神经网络,计算图,反向传播,激活函数,生物神经元

PPT:cs231n.stanford.edu/slides/2017/cs231n_2017_lecture4.pdf

etc. |

|---|

| 感谢者: |

葛荣存, Litost, 大大卷, 青叶, yleaves, todx, Hsinchu, 方少, sapper, rafale1003, Sloriac, qf129, lijun, 稻花香, H2P, 张扬, 叶童, 冰墨魂, SmallKing, 许黎之, hengxin1102, hchsoon

|

|---|

|

发表评论